はじめに ~データの「8割」を捨てていませんか? 生成AI活用を支える次世代データ基盤の正体~

これまで、企業のデータエンジニアや情シス担当者の主な武器は「SQL」でした。 売上データ、ログ、顧客マスタ……。これら「構造化データ」をSnowflakeやBigQueryなどのDWH(データウェアハウス)にきれいに格納し、SQLで集計してBIツールで可視化する。これが、長らくデータ活用の王道でした。

しかし、生成AIの登場により、ゲームのルールは劇的に変わりました。

AIが最もその力を発揮するのは、SQLで扱える「数値」ではなく、議事録、契約書、日報、画像、メールといった**「非構造化データ」**です。

これからのデータ基盤担当者に求められるのは、テーブル設計(ER図)のスキルだけではありません。「言葉の意味」や「文脈」をいかに管理し、AIに渡すかという、全く新しい設計思想です。

本稿では、AI時代の新たな主戦場となる「非構造化データ管理」の勘所と、乱立する技術スタックの中から自社に最適な解を見つけるための指針について解説します。

1. 企業の資産の「8割」はExcelの外にある

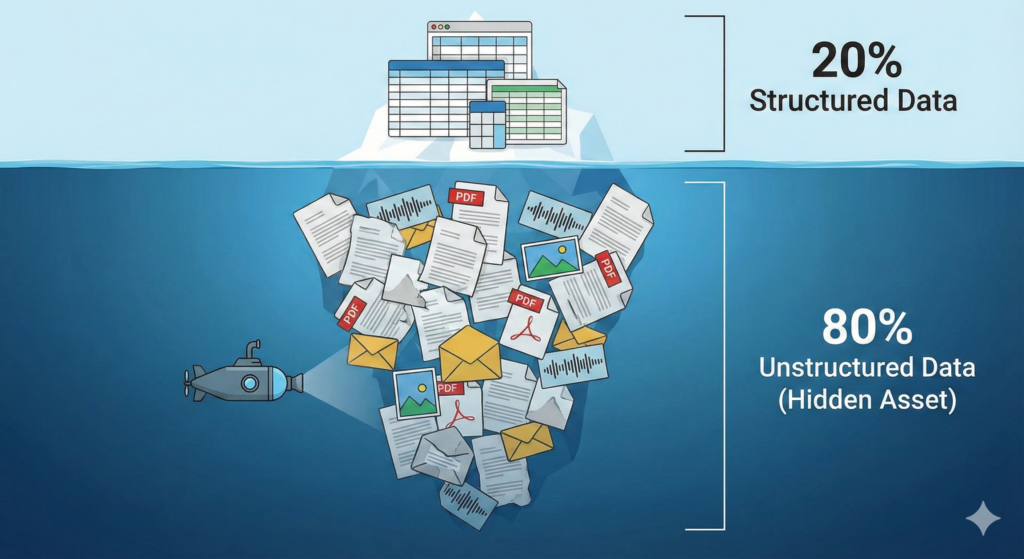

IT業界ではよく「企業の持つデータの80%は非構造化データである」と言われます。

これまでのデータ分析では、この8割は「活用困難なもの」としてファイルサーバーの奥底に眠らせておくか、あるいは無理やり構造化して「備考欄」に押し込むなど、情報を削ぎ落として扱うしかありませんでした。

しかし、生成AIはこの「捨てられていた8割」を宝の山に変えます。

- 以前: 「先月の売上が10%落ちた」ことしか分からない(構造化データの世界)

- 現在: 「なぜ落ちたのか?(競合の新製品の影響か、営業トークの不備か)」という文脈まで分析できる(非構造化データの世界)

この8割を活用できる基盤を持てるかどうかが、今後の企業の競争力を決定づけます。これからは、DWHの横に「非構造化データをネイティブに扱える保管庫」が必要になるのです。

2. ベクトルデータベースと「意味」の検索

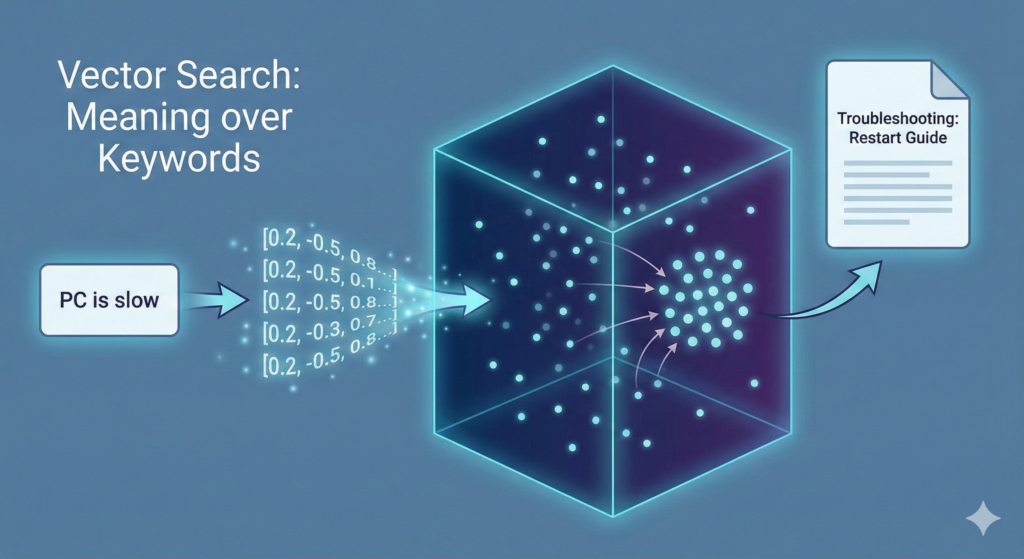

非構造化データを扱うための技術的なキーワードが「ベクトル検索(Vector Search)」です。

従来のキーワード検索が「単語の一致」を探すのに対し、ベクトル検索は文章を数値の羅列(ベクトル)に変換し、「意味の近さ」で情報を探します。これにより、「PCの調子が悪い」と検索して「再起動の手順」をヒットさせるような、人間的な検索が可能になります。

しかし、これを実装するのは容易ではありません。PDFをただ放り込めばいいわけではなく、適切なサイズに分割(チャンキング)し、ベクトル化(Embedding)するという、従来のETLとは異なる「非構造化データのためのパイプライン」を構築する必要があります。

3. 乱立するツール群:Snowflake、Databricks、Azure…どれを選ぶべきか?

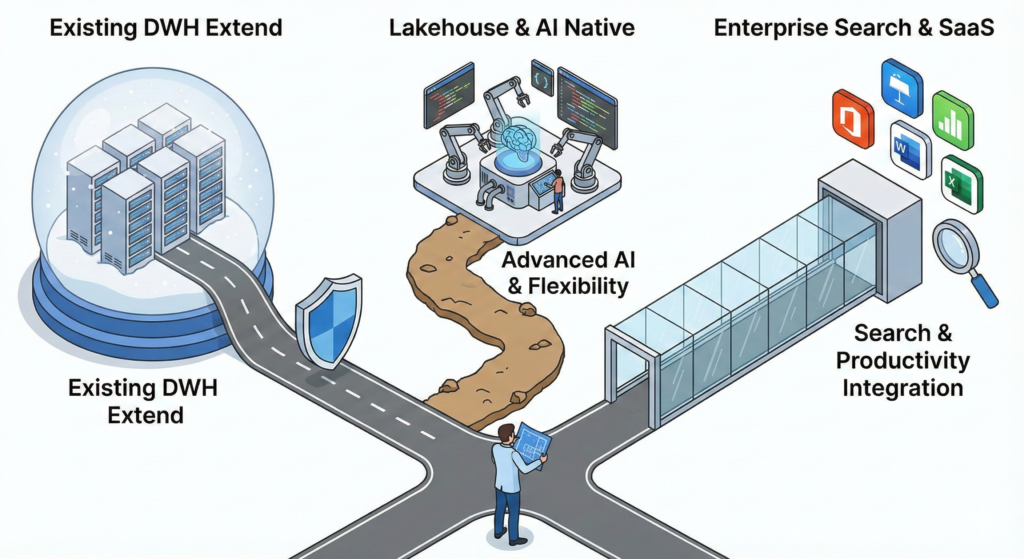

ここで多くの担当者が頭を抱えるのが、「どのツールを使えばいいのか?」という問題です。市場には優れたツールが溢れていますが、それぞれ「得意な戦場」が異なります。ここでは代表的な3つのパターンを例に挙げます。

パターンA:既存資産を活かす「Snowflake Cortex」

もし御社が既にデータ基盤としてSnowflakeを導入しているなら、**「Snowflake Cortex」**の活用が第一候補になります。 最大のメリットは「データ・グラビティ(データの重力)」です。データがある場所でそのままAI処理を行えるため、データを外部に持ち出すセキュリティリスクや手間がありません。SQLライクな構文でLLM関数を呼び出せるため、既存のデータエンジニアがスキルをスライドさせやすい点も魅力です。

パターンB:高度な処理とオープン性を重視する「Databricks」

画像解析や複雑な機械学習モデルの構築まで見据えている、あるいはエンジニアリングリソースが豊富な場合は、**「Databricks」**が強力な選択肢です。 「レイクハウス」アーキテクチャを標榜しており、非構造化データの扱いに長けています。オープンソースのモデルを活用したり、非常に細かい粒度でのデータ制御を行ったりする場合、その柔軟性が大きな武器になります。

パターンC:検索精度とMicrosoft連携の「Azure AI Search」

社内のドキュメント検索(エンタープライズサーチ)としての用途が主で、かつMicrosoft 365(TeamsやSharePoint)との連携を重視するなら、**「Azure AI Search」**が最適解になり得ます。 特に「ハイブリッド検索(キーワード検索とベクトル検索のいいとこ取り)」の機能が強力で、RAG構築において手っ取り早く高精度な回答を得やすいのが特徴です。

4. 「とりあえず全部入り」は失敗のもと

このように、ツールにはそれぞれの思想があります。

- 「SQL中心の文化を変えずにAIを取り入れたい」のか?

- 「データサイエンティスト主導で高度なモデルを作りたい」のか?

- 「Office製品との親和性を最優先したい」のか?

目的によって選ぶべき「武器」は全く異なります。最悪なのは、流行りのツールを導入したものの、現場のスキルセットと合わずに放置されたり、オーバースペックでコストだけが膨らんだりするケースです。

また、非構造化データは「権限管理」も鬼門です。データベースのように行・列単位での制御が難しいため、「役員会議の議事録がパート社員も検索できてしまった」という事故も起こり得ます。ツール選定と同時に、ガバナンス設計もセットで行わなければなりません。

結論:技術選定の前に「青写真」を描く

AI時代のデータ基盤構築において、「これさえ入れておけば正解」という銀の弾丸はありません。

重要なのは、特定のベンダーの宣伝文句に踊らされることではなく、**「自社のデータ環境、エンジニアのスキルセット、そして解決したい課題」**を冷静に見極め、最適な技術スタックを組み合わせる(コンポーザブルな)アーキテクチャを描くことです。

我々は特定のベンダーに縛られない中立的な立場から、御社の状況に合わせた最適なデータ基盤のグランドデザインを支援します。

「Snowflakeを使っているが、RAG部分はAzureを使うべきか?」 「Databricksを入れるほどではないが、ベクトル検索はしたい」

そのような悩みをお持ちであれば、まずは我々にご相談ください。ツール導入の前に、成功への「設計図」を一緒に描きましょう。